note Note générale

Un moratoire sur l'intelligence artificielle?

Ceci est vraiment gros: dans une lettre ouverte publiée le 29 mars 2023, des centaines de scientifiques, chercheur·e·s, entrepreneur·e·s, professeur·e·s et grands noms de l'industrie technologique demandent un moratoire pour mettre un frein à la course à l'IA qui carbure à plein régime depuis quelques mois. Ce ne sont pas des néo-luddites ici, des technophobes, réactionnaires ou anticapitalistes qui demandent une telle chose, mais des personnes comme Yoshua Bengio (Mila), Steve Wozniak (Apple), Elon Musk (SpaceX, Tesla & Twitter), Yuval Noah Harari (auteur de Sapiens), et plein d'autres.

Depuis quelques semaines, plusieurs gens disent qu'un "moratoire" est une lubie, une impossibilité, un vœu pieux, car "on n'arrête pas le progrès", parce que si on attend, on sera les perdants face à nos concurrents, des gens arriérés, dépassés par la vitesse du changement technologique, incapables de s'adapter à la situation. Or, ce que demandent aujourd'hui les ténors de l'industrie, c'est une pause, un temps pour réfléchir, pour mieux s'adapter à ces changements, prendre le temps de mesurer les impacts sociaux de l'IA générative et de la boîte de Pandore qui vient de s'ouvrir, avant de se lancer dans la course à GPT-5, 6, 7, 8, 9 ou 10, tout en licenciant les équipes de développement responsable (comme l'a fait Microsoft), comme une bande d'irresponsables.

Si la pandémie nous a appris une chose, c'est qu'il est possible d'arrêter, de ralentir, de mettre un frein pour des raisons de sécurité, d'intervenir politiquement en interrompant le flux des événements et le fonctionnement "normal" du système économique. Cette lettre ouverte appelle à un moratoire de 6 mois de la part de tous les laboratoires d'IA pour mettre en place des protocoles de sécurité, en demandant aux gouvernements de prendre leurs responsabilités en la matière, en encadrant convenablement l'industrie.

Qu'est-ce qui motivent les entreprises privées à revendiquer qu'on les régulent à ce point, quitte à interrompre la recherche pendant 6 mois (et les potentiels profits qui vont avec)? On peut faire l'hypothèse d'une potentielle crise de confiance vis-à-vis l'industrie de l'IA (risques réputationnels) ou un enjeu de positionnement stratégique (image de marque), mais peut-être aussi un souci bien réel de ne pas se lancer tête baissée dans des développements aux conséquences potentiellement incontrôlables pour l'humanité et la cohésion sociale (risques existentiels, dérives anti-démocratiques).

Je ne fais guère confiance à des gens comme Sam Altman, Elon Musk et autres, mais quand ceux-ci commencent à réellement avoir peur des innovations en cours, et demandent aux gouvernements de s'inquiéter davantage en matière d'encadrement, c'est un signe que l'auto-régulation du progrès algorithmique ne fonctionne pas. Il faut dès lors s'entendre sur des balises et des normes collectives pour "ré-encastrer" l'IA dans la société, au lieu que ça soit la société qui soit encastrée dans l'IA et absorbée par la logique algorithmique.

Qui plus est, je dirais qu'il devrait en aller de même avec un moratoire sur le rôle et l'impact des technologies numériques/algorithmiques dans le secteur de l'éducation, de la santé, des services sociaux, de la police, etc. Des états généraux, des consultations publiques, des enquêtes et autres exercices d'intelligence collective pour orienter ces développements, au lieu d'embarquer dans le train de façon irréfléchie, comme si le progrès technique allait magiquement régler tous nos problèmes.

Cela n'est pas sans rappeler le mythe de Prométhée, qui vola le feu aux dieux pour le donner aux humains, et qui fut puni par Zeus pour sa démesure. La raison prométhéenne qui anime plusieurs dirigeants de la Silicon Valley semble ici douter d'elle-même, et c'est bon signe. On ne sortira pas du capitalisme algorithmique, mais peut-être d'une certaine phase du capitalisme algorithmique dérégulé, frénétique et débridé, au profit de quelque chose comme un capitalisme régulé par l'État. Je n'ai pas trop d'espoir dans cette transition, mais je salue les signes de vigilance et de responsabilité que commencent à prendre certains acteurs hyperpuissants de cette industrie, en tirant la sonnette d'alarme.

Enfin, j'oppose souvent l'approche éthique de l'IA responsable avec celle de la "théorie critique", mais je crois ici qu'on doit s'entendre collectivement, des plus techno-optimistes aux plus techno-pessimistes, pour dire qu'un moratoire est nécessairement et que la société doit prendre un bas de recul sur cette trajectoire qu'elle semble emprunter sur le "pilote automatique". Cela vaut tant pour l'IA que pour la crise climatique, qui représentent les deux plus grands défis du XXIe siècle à mon avis.Voici la traduction française de cette lettre ouverte dont le titre est on ne peut plus clair: Pause Giant AI Experiments.

"Nous demandons à tous les laboratoires d'IA d'interrompre immédiatement, pour une durée d'au moins six mois, la formation de systèmes d'IA plus puissants que GPT-4.

Les systèmes d'IA dotés d'une intelligence compétitive avec celle de l'humain peuvent présenter des risques profonds pour la société et l'humanité, comme le montrent des recherches approfondies et comme le reconnaissent les principaux laboratoires d'IA. Comme l'indiquent les principes d'IA d'Asilomar, largement approuvés, l'IA avancée pourrait représenter un changement profond dans l'histoire de la vie sur Terre, et devrait être planifiée et gérée avec l'attention et les ressources nécessaires.

Malheureusement, ce niveau de planification et de gestion n'existe pas, même si les derniers mois ont vu les laboratoires d'IA s'enfermer dans une course incontrôlée pour développer et déployer des esprits numériques toujours plus puissants que personne - pas même leurs créateurs - ne peut comprendre, prédire ou contrôler de manière fiable.

Les systèmes d'IA contemporains deviennent aujourd'hui compétitifs sur le plan humain pour des tâches générales, et nous devons nous interroger : Devons-nous laisser les machines inonder nos canaux d'information de propagande et de mensonges ? Devrions-nous automatiser tous les emplois, y compris ceux qui sont gratifiants ? Devons-nous développer des esprits non humains qui pourraient un jour être plus nombreux, plus intelligents, plus obsolètes et nous remplacer ? Devons-nous risquer de perdre le contrôle de notre civilisation ? Ces décisions ne doivent pas être déléguées à des leaders technologiques non élus. Les systèmes d'IA puissants ne doivent être développés que lorsque nous sommes certains que leurs effets seront positifs et que leurs risques seront gérables. Cette confiance doit être bien justifiée et augmenter avec l'ampleur des effets potentiels d'un système. La récente déclaration d'OpenAI concernant l'intelligence artificielle générale indique "qu'à un moment donné, il pourrait être important d'obtenir un examen indépendant avant de commencer à former les futurs systèmes, et pour les efforts les plus avancés d'accepter de limiter le taux de croissance du calcul utilisé pour créer de nouveaux modèles". Nous sommes d'accord. C'est maintenant qu'il faut agir.

C'est pourquoi nous demandons à tous les laboratoires d'IA d'interrompre immédiatement, pendant au moins six mois, la formation de systèmes d'IA plus puissants que le GPT-4. Cette pause devrait être publique et vérifiable, et inclure tous les acteurs clés. Si une telle pause ne peut être mise en place rapidement, les gouvernements doivent intervenir et instaurer un moratoire.Les laboratoires d'IA et les experts indépendants devraient profiter de cette pause pour élaborer et mettre en œuvre conjointement un ensemble de protocoles de sécurité communs pour la conception et le développement de l'IA avancée, rigoureusement contrôlés et supervisés par des experts externes indépendants. Ces protocoles devraient garantir que les systèmes qui y adhèrent sont sûrs au-delà de tout doute raisonnable, ce qui ne signifie pas une pause dans le développement de l'IA en général, mais simplement un recul par rapport à la course dangereuse vers des modèles de boîte noire toujours plus grands et imprévisibles, dotés de capacités émergentes.La recherche et le développement dans le domaine de l'IA devraient être recentrés sur l'amélioration de la précision, de la sécurité, de l'interprétabilité, de la transparence, de la robustesse, de l'alignement, de la fiabilité et de la loyauté des systèmes puissants et modernes d'aujourd'hui.

Parallèlement, les développeurs d'IA doivent collaborer avec les décideurs politiques pour accélérer considérablement le développement de systèmes robustes de gouvernance de l'IA. Ceux-ci devraient au minimum comprendre : des autorités réglementaires nouvelles et compétentes dédiées à l'IA ; la surveillance et le suivi des systèmes d'IA hautement performants et des grands pools de capacité de calcul ; des systèmes de provenance et de filigrane pour aider à distinguer le réel du synthétique et pour traquer les fuites de modèles ; un écosystème robuste d'audit et de certification ; la responsabilité pour les dommages causés par l'IA ; un financement public robuste pour la recherche technique sur la sécurité de l'IA ; et des institutions dotées de ressources suffisantes pour faire face aux perturbations économiques et politiques dramatiques (en particulier pour la démocratie) que l'IA provoquera.

L'humanité peut jouir d'un avenir florissant grâce à l'IA. Ayant réussi à créer des systèmes d'IA puissants, nous pouvons maintenant profiter d'un "été de l'IA" au cours duquel nous récolterons les fruits de nos efforts, concevrons ces systèmes pour le plus grand bénéfice de tous et donnerons à la société une chance de s'adapter. La société a mis en pause d'autres technologies aux effets potentiellement catastrophiques pour elle, et nous pouvons faire de même ici. Profitons d'un long été de l'IA et ne nous précipitons pas sans préparation vers l'automne."

*Bref retour sur la lettre ouverte "Pause Giant AI Experiments: An Open Letter", appelant à un moratoire de six mois sur le développement des larges modèles de langage (comme GPT-4).

1. Il y a eu un peu de confusion au niveau de la liste des signataires, car certains noms (comme Sam Altman de OpenAI et Yann Le Cun) semblent avoir été ajoutés à la blague par des personnes anonymes. Il n'en demeure pas moins que plusieurs gros noms de l'industrie sont là, donnant ainsi de la crédibilité à l'idée d'un moratoire et d'une régulation plus forte de l'IA par les pouvoirs publics.

2. À noter les absents: Google, Amazon, Facebook, Apple et Microsoft, qui entrent tous actuellement dans la course à l'IA générative suite au succès fulgurant de OpenAI. Si plusieurs instituts de recherche sur le développement responsable de l'IA et les enjeux de sécurité tirent la sonnette d'alarme, les principaux joueurs visés par cette lettre manquent à l'appel; encore une fois, les intérêts économiques priment sur les externalités négatives et la responsabilité morale. À moins d'une intervention forte du gouvernement américain pour accélérer la législation en matière d'IA (en six mois, il y a peu de chances que quelque chose aboutisse), rien n'arrêtera l'actuelle course aux armements algorithmiques, ni la quête effrénée de l'intelligence artificielle générale (AGI), Saint Graal de plusieurs personnes travaillant dans le domaine.

3. Cette lettre ouverte révèle une tension déjà présente dans le milieu de la recherche et l'IA: les partisans de la régulation, qui croient que l'IA amènera ses pleins bénéfices à condition que des garde-fous soient mis en place; et les partisans de la vitesse, qui considèrent qu'il faut s'adapter chemin faisant, en évitant les barrières à l'innovation et en appliquant le slogan "move fast dans break things". Ces derniers utilisent le discours l'IA responsable ou du AI safety de manière rhétorique, sans s'engager à auto-limiter le rythme de la recherche et développement. Ce débat entre "régulationnistes" et "accélérationnistes" se révèle au grand jour, et il semble que les GAFAM soient clairement dans le deuxième camp, intérêts économiques obligent.

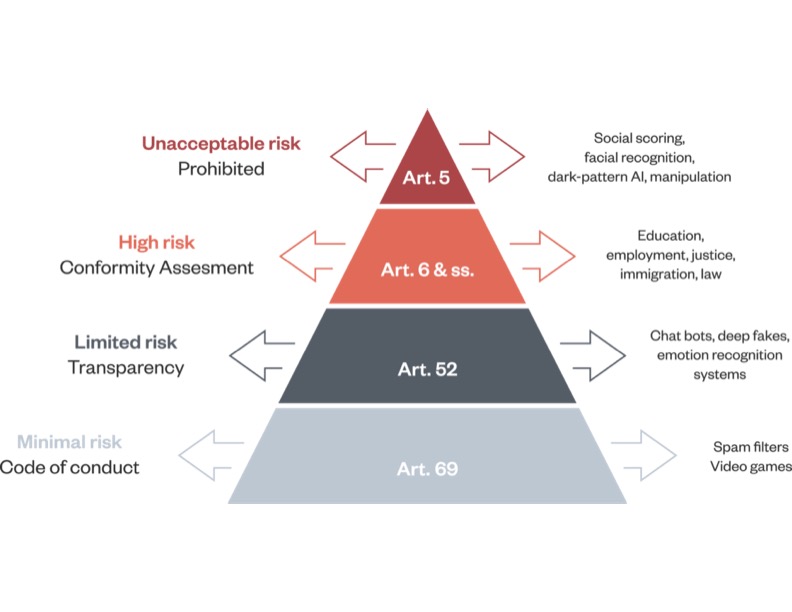

4. Encore une fois, il faut se tourner vers l'Europe en matière d'innovation législative, comme ce fut le cas avec le Règlement général sur la protection des données (RGPD) adopté en 2016. En 2021, la Commission européenne a déposé un projet de loi sur l'intelligence artificielle (AI Act) qui devrait être adopté cette année. De quoi s'agit-il? Ce projet vise à classer les applications algorithmiques en fonction d'une échelle de risque à 4 paliers, et de réguler le déploiement de ces innovations en conséquence, allant de la permissivité à une interdiction totale (voir figure plus bas).

5. Beaucoup de gens évoquent le fait que le "génie est sorti de la lampe" et qu'on ne peut renverser la vapeur; il est déjà trop tard. Or, il y a des cas récents de développements technologiques qui ont été interdits complètement: clonage humain, recherche sur les gains de fonction de virus, modification des lignées génétiques humaines, eugénisme, etc. Dans ce cas-ci, il ne s'agit pas d'interdire l'IA en soi ou de stopper la création de robots comme ChatGPT, mais de mettre en lumière une législation robuste pour encadrer leur déploiement et mitiger les risques.

6. Pour un aperçu des nombreux risques des larges modèles de langage, voici le résumé d'un article d'une soixantaine de pages qui identifie 21 risques: "Ce document a pour but d'aider à structurer le paysage des risques associés aux larges modèles de langage (LLM). Afin de favoriser les avancées en matière d'innovation responsable, il est nécessaire d'avoir une compréhension approfondie des risques potentiels posés par ces modèles. Un large éventail de risques établis et anticipés est analysé en détail, en s'appuyant sur l'expertise et la littérature multidisciplinaires de l'informatique, de la linguistique et des sciences sociales.Nous décrivons six domaines de risque spécifiques : I. Discrimination, exclusion et toxicité, II. Risques liés à l'information, III. Dangers liés à la désinformation, V. Utilisations malveillantes, V. Dangers liés à l'interaction homme-machine, VI. Automatisation, accès et dommages environnementaux. Le premier domaine concerne la perpétuation des stéréotypes, des discriminations injustes, des normes d'exclusion, du langage toxique et des performances inférieures par groupe social pour les LLM. Le deuxième se concentre sur les risques de fuites de données privées ou d'inférences correctes d'informations sensibles. La troisième porte sur les risques découlant d'informations médiocres, fausses ou trompeuses, y compris dans des domaines sensibles, et sur les risques en chaîne tels que l'érosion de la confiance dans les informations partagées. Le quatrième aborde les risques liés aux acteurs qui tentent d'utiliser les LLM pour nuire. La cinquième partie se concentre sur les risques spécifiques aux LLM utilisés pour étayer les agents conversationnels qui interagissent avec les utilisateurs humains, y compris l'utilisation dangereuse, la manipulation ou la tromperie. Le sixième aborde les risques liés à l'environnement, à l'automatisation des emplois et à d'autres défis susceptibles d'avoir un effet disparate sur différents groupes sociaux ou communautés."

Comme le résume de façon ironique Evgeny Morozov dans un tweet du 28 mars : "2016: Fake news is bad! 2023: We have democratized fake news! Now with APIs and plugins!"

7. Pour terminer, ces réflexions me rappellent que nous vivons toujours dans la "société du risque", comme le décrivait bien Ulrich Beck dès 1986: "L'État, la science et l'industrie exhortent la population à monter à bord d'un avion pour lequel aucune piste d'atterrissage n'a été construite à ce jour." Certains membres de la communauté scientifique et de l'industrie nous demandent de construire la piste d'atterrissage, mais la plupart des États, des géants du numérique et des startups sautent à pieds joints dans l'avion en demandant que celle-ci accélère encore davantage.

note Note(s) liée(s)

bookmark Terme(s) relié(s)

10 juillet 2023

10 juillet 2023

Alignement de l'intelligence artificielle (IA)

10 juillet 2023 12 juillet 2023

12 juillet 2023

Armement algorithmique

12 juillet 2023 10 juillet 2023

10 juillet 2023

Autorégulation des algorithmes

10 juillet 2023 12 juin 2023

12 juin 2023

Capitalisme algorithmique

12 juin 2023 9 juin 2023

9 juin 2023

Cohésion sociale

9 juin 2023 7 juin 2023

7 juin 2023

Consultation

7 juin 2023 10 juillet 2023

10 juillet 2023

Donnée sensible

10 juillet 2023 10 juillet 2023

10 juillet 2023

Eugénique

10 juillet 2023 10 juillet 2023

10 juillet 2023

Externalité

10 juillet 2023 10 juillet 2023

10 juillet 2023

Filigrane numérique

10 juillet 2023 23 mars 2023

23 mars 2023

GAFAM

23 mars 2023 14 janvier 2023

14 janvier 2023

Gouvernance

14 janvier 2023 10 juillet 2023

10 juillet 2023

Image de marque

10 juillet 2023 14 janvier 2023

14 janvier 2023

Impact social

14 janvier 2023 14 janvier 2023

14 janvier 2023

Intelligence artificielle (IA)

14 janvier 2023 10 juillet 2023

10 juillet 2023

Intelligence artificielle (IA) générative

10 juillet 2023 14 janvier 2023

14 janvier 2023

Intelligence collective

14 janvier 2023 10 juillet 2023

10 juillet 2023

Intelligence générale artificielle (AGI)

10 juillet 2023 10 juillet 2023

10 juillet 2023

Interprétabilité

10 juillet 2023 10 juillet 2023

10 juillet 2023

Large modèle de langage (LLM) - Grand modèle de langage (GML)

10 juillet 2023 13 juin 2023

13 juin 2023

Moratoire

13 juin 2023 10 juillet 2023

10 juillet 2023

Néo-luddisme

10 juillet 2023 10 juillet 2023

10 juillet 2023

Protocole de sécurité

10 juillet 2023 10 juillet 2023

10 juillet 2023

Raison prométhéenne

10 juillet 2023 10 juillet 2023

10 juillet 2023

Recherche et développement (R&D)

10 juillet 2023 10 juillet 2023

10 juillet 2023

Responsabilité morale

10 juillet 2023 10 juillet 2023

10 juillet 2023

Technophobie

10 juillet 2023 10 juillet 2023

10 juillet 2023

Théorie critique

10 juillet 2023Carnet(s) relié(s)

file_copy

217 notes

file_copy

217 notes

Numérique et données - Enjeux, leviers et stratégies

file_copy 217 notes file_copy

10 notes

file_copy

10 notes

Réflexions de Jonathan Durand Folco

file_copy 10 notesAuteur·trice(s) de note

Contacter l’auteur·trice Discuter de la note Plus d’informationsPublication

30 mars 2023

Modification

12 juillet 2023 13:31

Visibilité

public